L’ECPAD participe depuis le mois d’avril à un programme d’intelligence artificielle avec le Labo BI et Big data de la délégation à la transformation et à la performance ministérielles du SGA. Valérie Plier, Manager du LABO BI et Big Data au SGA, revient sur ce partenariat.

1 – Pourriez-vous nous présenter le projet Vision360 qui se base sur l’apprentissage automatique ? Quels en sont les objectifs ?

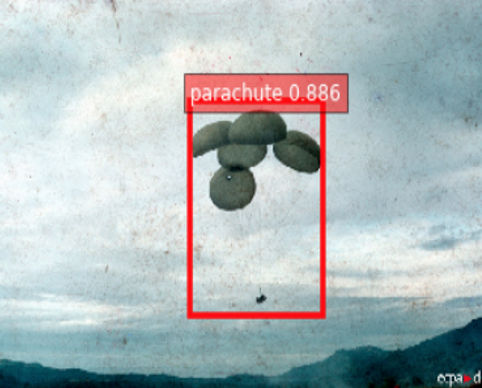

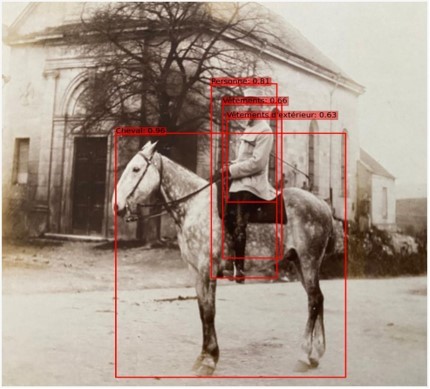

Le projet Vision360 a démarré en 2020 à titre expérimental. Il a été réalisé par Rebecca Leygonie, actuellement en thèse au sein du Labo BI et Big data après sa période d’apprentissage. Ce projet vise à utiliser l’intelligence artificielle pour détecter, localiser et labelliser (associer une étiquette) les objets présents dans les images de l’ECPAD.

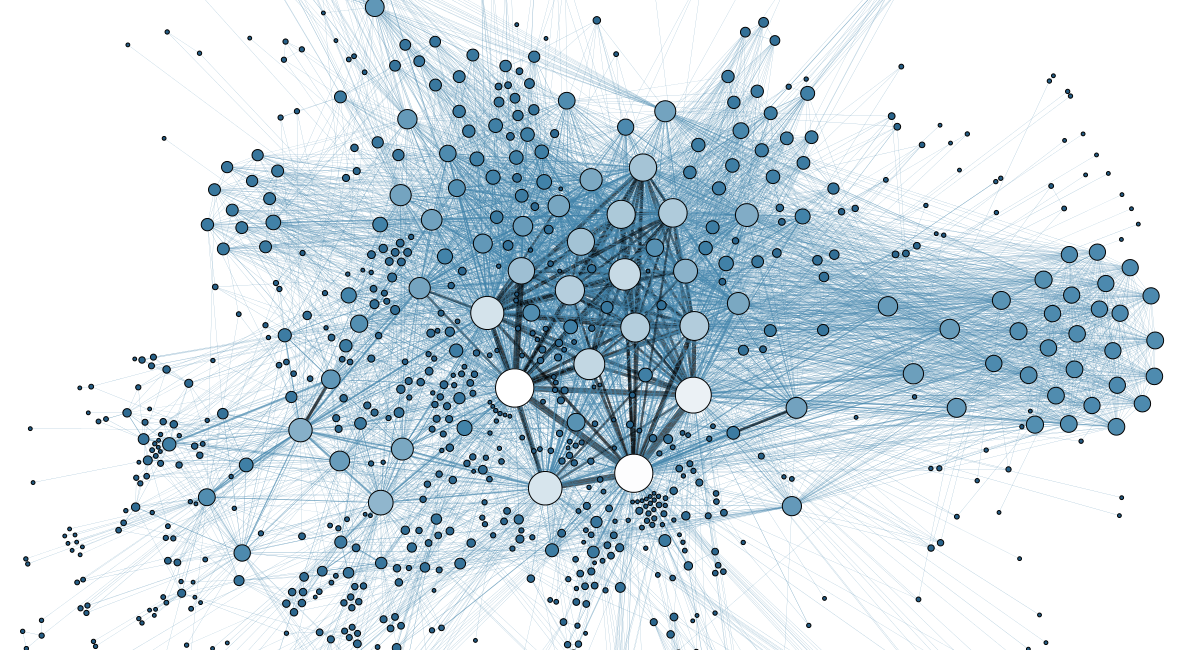

L’objectif est d’entraîner un réseau de neurones artificiels, s’inspirant du cortex visuel des animaux, à la reconnaissance d’images. Dans un premier temps, nous allons entraîner un algorithme à la détection d’objets multiples sur des images trouvées sur internet et libres de droit (open source). Dans un second temps, cet algorithme – une fois entraîné et performant – va être téléchargé sur les serveurs de l’ECPAD afin qu’il puisse traiter les images de l’établissement. L’algorithme va permettre d’automatiser la détection d’objets dans les images de l’ECPAD et de les pré-annoter automatiquement. Cela va permettre de faciliter le travail des archivistes qui n’auront plus à annoter de façon manuelle les images, et de supprimer le risque d’erreur.

2 – Quelles vont être les différentes étapes du projet ?

L’opération de détection d’objets multiclasse est découpée en 4 étapes :

La première étape consiste à extraire les noms d’objets du thésaurus utilisés par les archivistes pour l’annotation. Le thésaurus contient plus de 14 000 mots dont des lieux, des ambiances (détecter différentes sortes d’émotions au niveau des visages ou du contexte par exemple), des saisonnalités (détecter les saisons en fonction de l’aspect et de la couleur des arbres ou du ciel, par exemple), etc. Nous avons donc utilisé des modèles d’extraction d’entités nommées (NER) pour récupérer seulement les noms d’objets.

Lors de la deuxième étape, nous avons fait du scrapping d’images (récupération automatisée d’images libres de droit sur internet) sur des moteurs de recherche d’images à partir de la liste récupérée (200 objets). Nous sommes partis du principe que les X premiers résultats d’une requête d’un mot sur un moteur de recherche d’images représentent l’objet dans sa totalité.

La troisième étape permet d’empêcher le modèle de faire du « sur-apprentissage », c’est-à-dire faire en sorte qu’il n’apprenne pas sur des exemples trop proches les uns des autres et puisse ainsi généraliser son apprentissage. Nous faisons de l’augmentation de données en effectuant de légères modifications de l’image (rotation, contraste, etc.) pour enrichir le jeu de données d’entraînement. Enfin, une fois le jeu de données d’entraînement constitué, nous entraînons le modèle en testant différents hyper-paramètres pour obtenir les meilleures performances.

3 – À quelles échéances les premiers résultats sont-ils attendus ? Quels sont les défis actuels à relever en termes de Big Data ?

Le projet Vision360 est en train d’être déployé sur les serveurs de l’ECPAD pour un premier test. Il s’agit de vérifier l’annotation d’images à partir de 200 labels sur lesquels est entraîné le modèle. Une fois ces tests effectués, nous souhaitons affiner le modèle pour qu’il puisse détecter des objets plus précis, en fonction des besoins de l’ECPAD.

Ce projet consiste à automatiser l’annotation de 70 000 d’images à partir d’un modèle entraîné sur des images open source. Il s’agit de générer des images proches du cas d’usage pour assurer une bonne inférence du modèle. Le projet vision360 utilise donc plusieurs outils et approches développés pour répondre aux problématiques du Big Data.